详细介绍

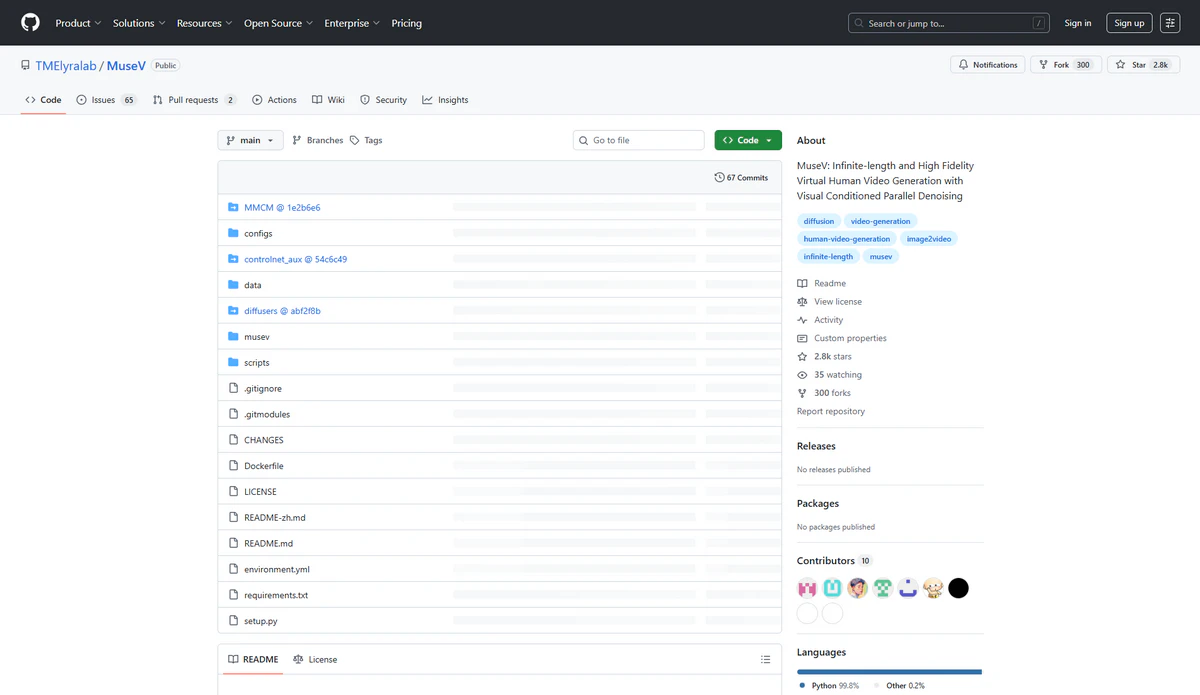

MuseV是由腾讯音乐娱乐集团的天琴实验室(TMElyra Lab)开源的虚拟人视频生成框架,基于扩散模型技术开发。以下是关于 MuseV 的详细介绍:

技术特点

- 无限时长生成:突破传统模型时长限制,支持生成无限时长的高一致性虚拟人视频,实测可稳定输出 30 分钟以上。

- 多模态控制:支持多种生成模式,包括 Image2Video(图像到视频)、Text2Image2Video(文本到图像到视频)、Video2Video(视频到视频)。此外,它还支持动作捕捉、精准口型同步(MuseTalk 技术实现 95% 发音匹配度)以及风格迁移(支持写实、二次元、水墨等 20 多种风格一键切换)。

- 高保真度输出:支持 1080P 分辨率输出,毛发、织物物理模拟逼近真实,每秒 24 帧流畅度,支持光影实时演算。

- 极速生成能力:在 RTX 4090 环境下,1 分钟视频生成仅需 90 秒,比 RunwayML 快 3 倍,比 Pika Labs 快 5 倍。

- 兼容性强:与 Stable Diffusion 生态系统兼容,支持使用

base_model、lora、controlnet等工具。同时,还支持多参考图像技术,如IPAdapter、ReferenceOnly、ReferenceNet、IPAdapterFaceID等。

如何使用

- 环境部署:通过 Git 克隆项目,并使用 Conda 创建环境,安装相关依赖。

- 基础生成:输入单张角色图及动作描述,即可输出视频。

- 高级控制:通过 JSON 配置文件定义镜头运动、微表情序列等。

- 批量渲染:支持多 GPU 并行处理,单卡日均可产出 100 + 分钟内容。

开源信息

MuseV 的开源地址为:- GitHub:https://github.com/TMElyralab/MuseV

- HuggingFace:https://huggingface.co/TMElyralab/MuseV

优势与不足

- 优势:

- 长视频生成能力强:可生成 30 分钟以上连续视频,而竞品上限多为 5 分钟。

- 资源消耗优化:8GB 显存可运行基础模型。

- 开源可控性高:允许修改神经网络架构。

- 多语言适配:支持中、英、日等 12 种语言口型同步。

- 不足:

- 硬件门槛高:需 RTX 3080 以上显卡才能流畅运行。

- 学习曲线陡峭:非技术用户需掌握 Python 基础。

- 动态细节不足:快速转身时发丝物理模拟可能失真。

- 商业授权限制:生成内容不可直接商用。

应用场景

- 影视预演:低成本制作分镜头动画。

- 虚拟主播:实现 7×24 小时直播带货。

- 教育科普:让历史人物复现讲解复杂概念。

- 游戏开发:批量生成 NPC 动态剧情。